一、简介

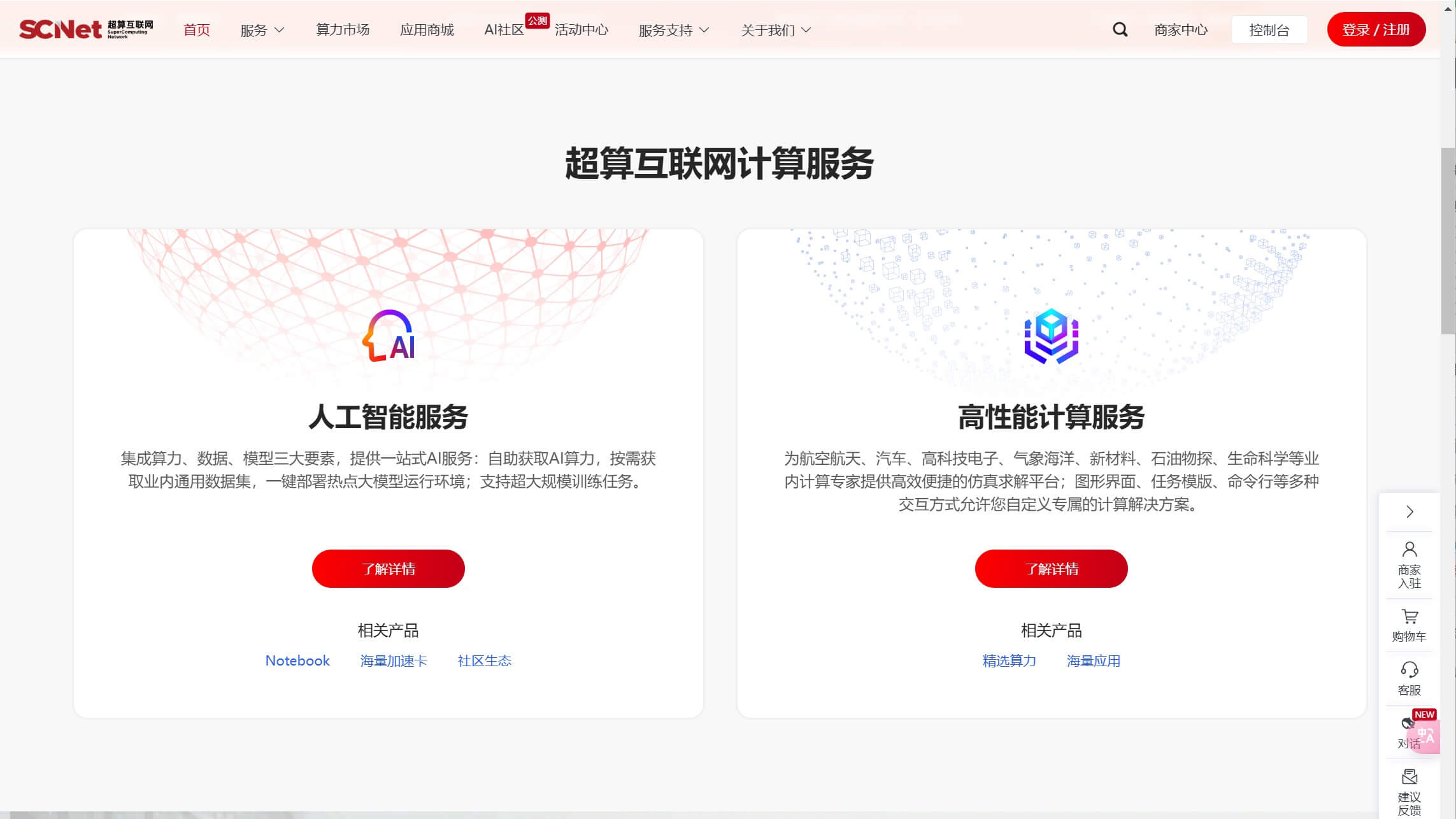

超算互联网平台(https://www.scnet.cn/)是由国家支持的一体化高性能计算服务平台,旨在连接算力供给、应用开发、运营服务等产业生态资源,构建覆盖全国的算力调度网络和协作生态。其核心目标是通过异构融合、开放合作的技术路径,打造国家先进算力底座,支撑数字中国建设,推动AI、科学计算等领域的普惠发展

二、平台功能

- 算力调度与资源整合

支持全国多中心算力资源的智能调度,用户可按需调用通用计算资源、异构加速卡(如国产深算智能加速卡、NVIDIA L20等),覆盖从单卡到集群的多样化需求13。 - AI开发与模型服务

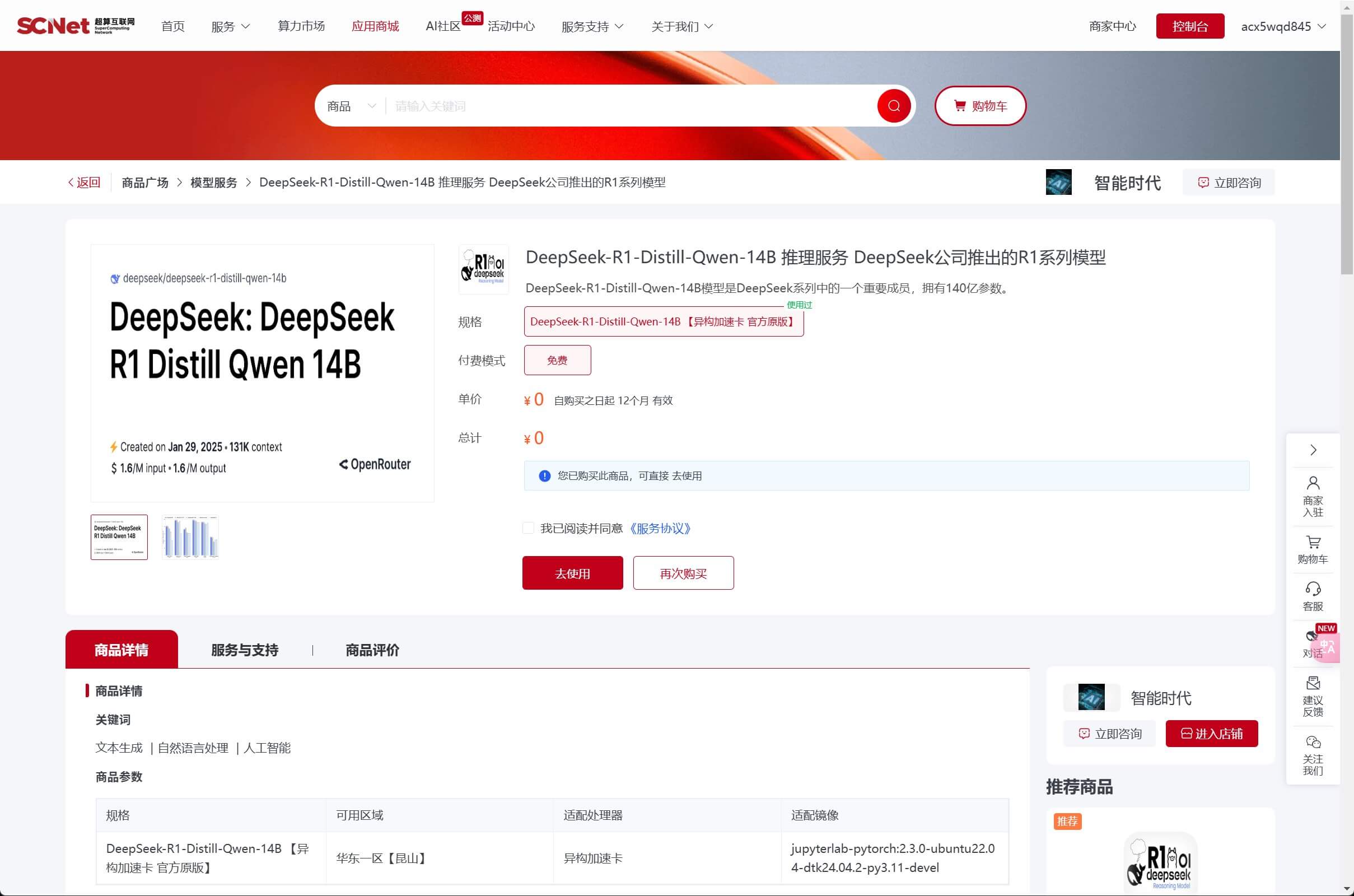

提供预训练模型(如DeepSeek、Llama3、Qwen等)、模型微调工具(PEFT框架)及快速推理服务,支持大模型的在线训练、部署及私有化定制510。

- 应用生态支持

内置应用商城,提供丰富的开源数据集(如COCO2017)、模型镜像(如Stable Diffusion、YOLOv8)及开发环境(JupyterLab、PyTorch/TensorFlow镜像),简化部署流程711。 - 开发与运维管理

支持从上传算例、提交作业到结果下载的全流程管理,并提供7*24小时技术支持和环境优化服务37。

三、平台特点

- 异构加速卡性能突出

国产深算智能加速卡提供64GB显存,FP16/BF16算力达196 TFLOPS,支持大模型全精度训练,性价比高于NVIDIA L20等竞品24。 - 生态兼容性强

兼容PyTorch、TensorFlow等主流框架,支持PEFT微调、LoRA适配等技术,用户代码无需大规模修改即可迁移。 - 极速数据传输与安全保障

通过内网传输模型和数据,下载速度远超公网;平台符合三级等保标准,数据加密与隐私保护机制完善。 - 普惠性与高性价比

提供0.01元/小时的国产卡体验活动,按需付费模式降低中小企业和个人用户的算力成本。

四、支持的平台与模型

- 框架:PyTorch、TensorFlow、Hugging Face Transformers等。

- 模型类型:涵盖视觉(YOLOv8、ResNet)、语言(Llama3、Qwen、DeepSeek)、多模态(Stable Diffusion)等。

- 国产模型生态:深度适配DeepSeek系列(R1、V3、Coder)、ChatGLM2-6B等国产大模型,支持在线推理与定制化训练。

五、价格与服务模式

- 按需计费:国产加速卡低至0.01元/小时,NVIDIA显卡按市场价浮动,支持关机暂停计费。

六、用户使用评价

- 优势反馈:

- 显存充足,64GB显存轻松应对FP32精度的大模型推理。

- 内网传输极速,模型下载与训练数据加载效率高。

- 客服响应及时,技术支持覆盖从环境配置到代码调试的全流程。

- 待优化点:

- 国产卡微调速度较NVIDIA显卡慢(如Qwen微调耗时7小时 vs. 4070Ti Super的2.5小时)

- 部分用户界面功能(如实例关闭镜像保存、服务端口配置)需进一步优化