DeepSeek 最近真的太火了,但官网今天又又又挂了,总是出现服务器繁忙问题。之前给大家分享了几个免费官方平替的渠道:https://www.tudingai.com/2009.html

今天再来给大家分享如何将DeepSeek R1 部署到自己的电脑本地,让你实现AI真正的自由问答!我会分享两种部署方法,一种超级简单,下载解压即可。另一种使用更灵活便捷,部署也比较简单。

方法一:

该方法来自B站UP主@万能君的软件库的打包版,无需搭建环境,解压即用,适合小白用户体验。

下载地址:https://pan.quark.cn/s/1163f7da1778

该工具压缩包大小足足 36.5GB ,下载后直接解压即可使用。里面包含了,1.5b、7b、14b、32b、四款蒸馏后的DeepSeek R1 模型。

对硬件要求,你的电脑最低要有8GB的内存,才能流畅运行1.5b的最小模型,7b和14b需要32GB以上的内存,32b的模型需要大于128GB的内存。根据你的电脑硬件情况,选择最大的模型即可,模型越大效果越好。

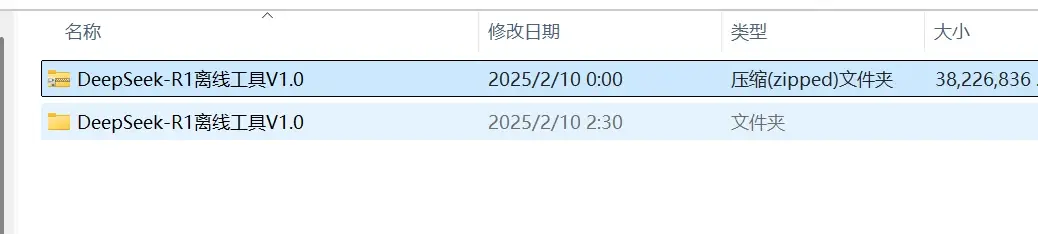

1,下载DeepSeek – R1离线工具,并解压。下载前注意你的电脑存储空间。下载后直接解压即可~

2,解压后,打开文件夹,找到“DeepSeek-R1离线工具V1.0”执行文件,双击运行。

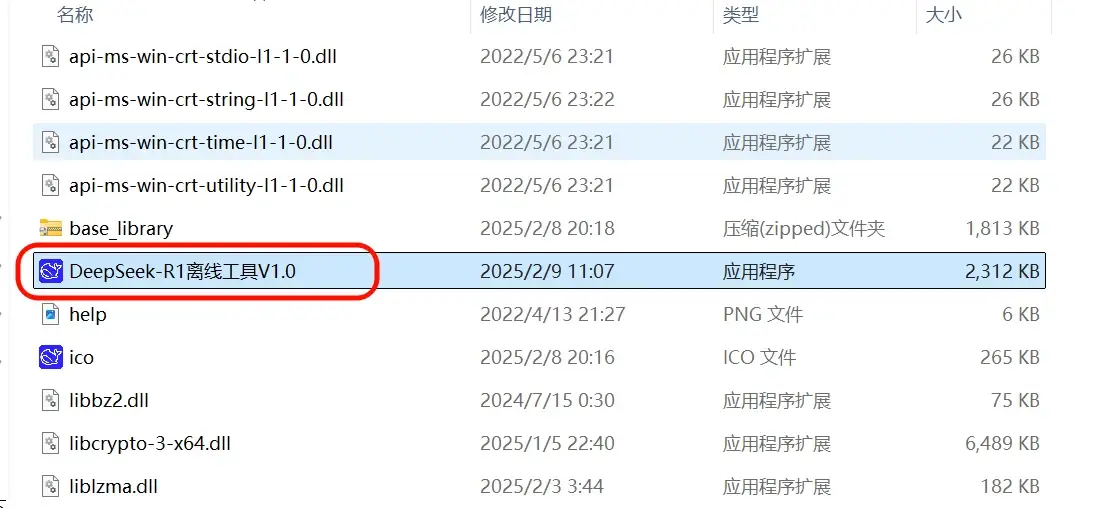

3,然后直接点击一键启动

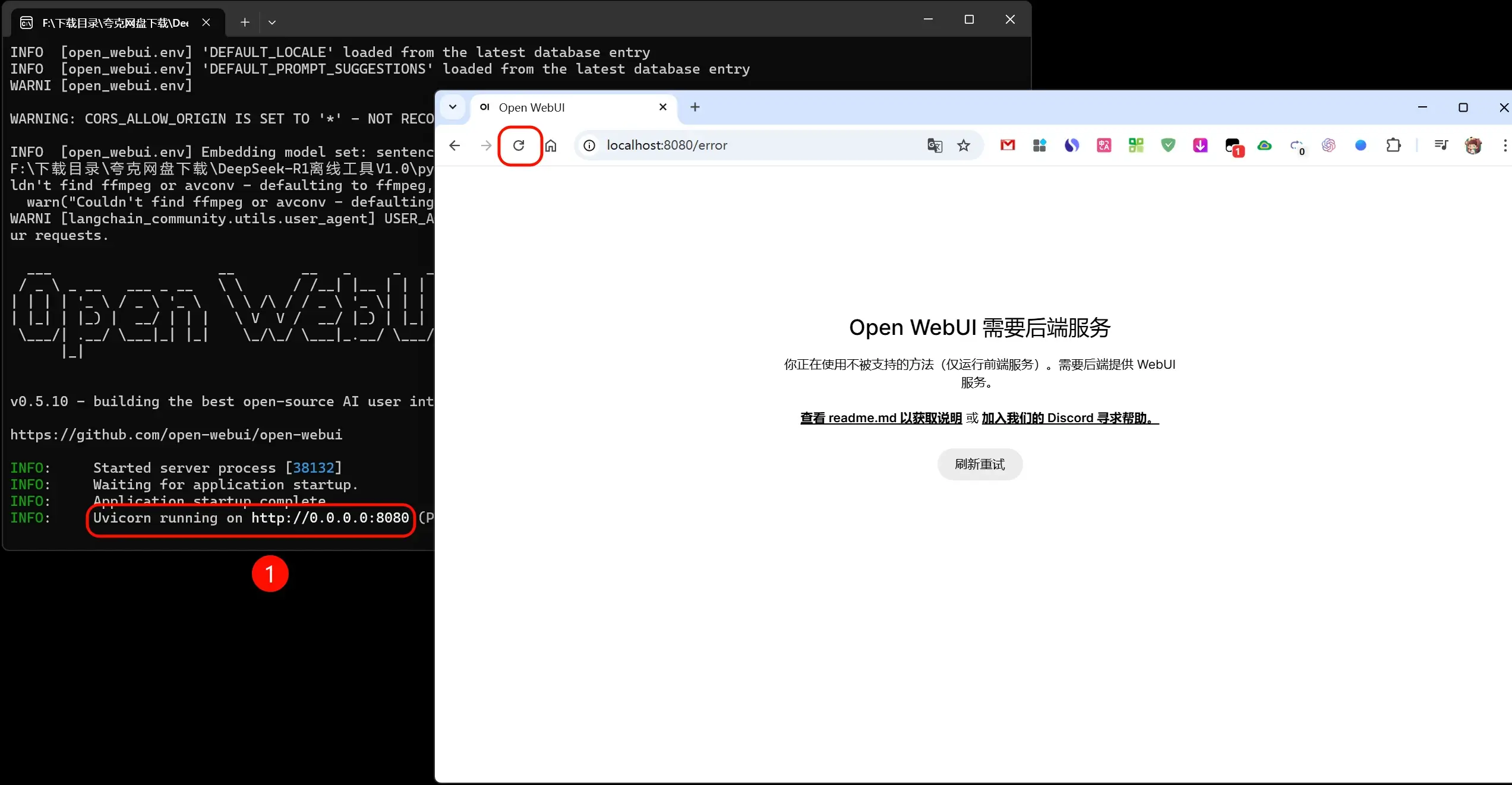

4,这时候会自动打开浏览器的一个窗口,这个窗口会先报错。我们需要等待cmd命令窗口出现 Uvicorn running on http://0.0.0.0:8080 (Press CTRL+C to quit) ,这一行命令,然后去刷新你的浏览器窗口。

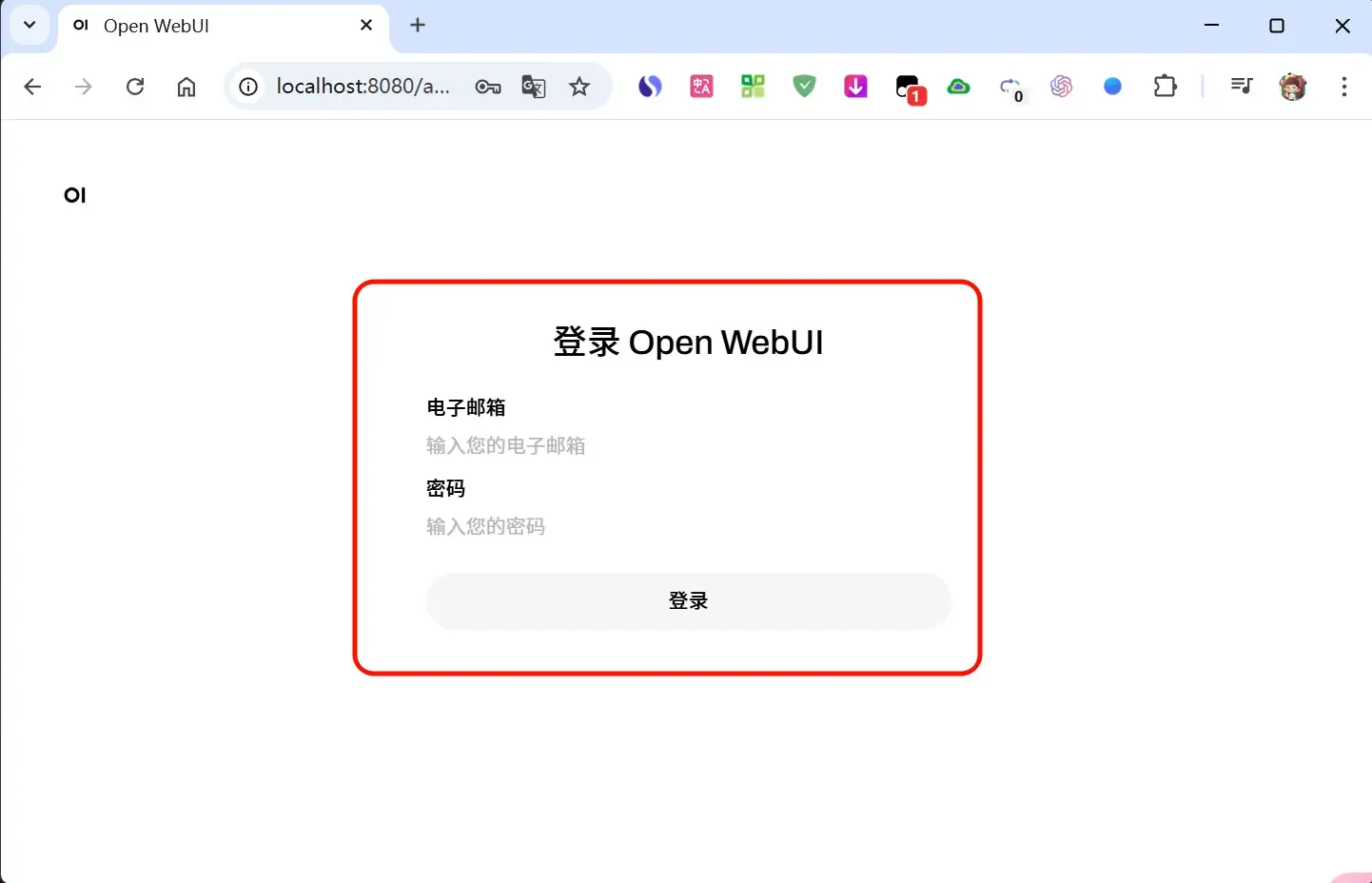

5,刷新后,我们就进入了open wecui 页面,输入你的邮箱和设置一个密码即可登录。

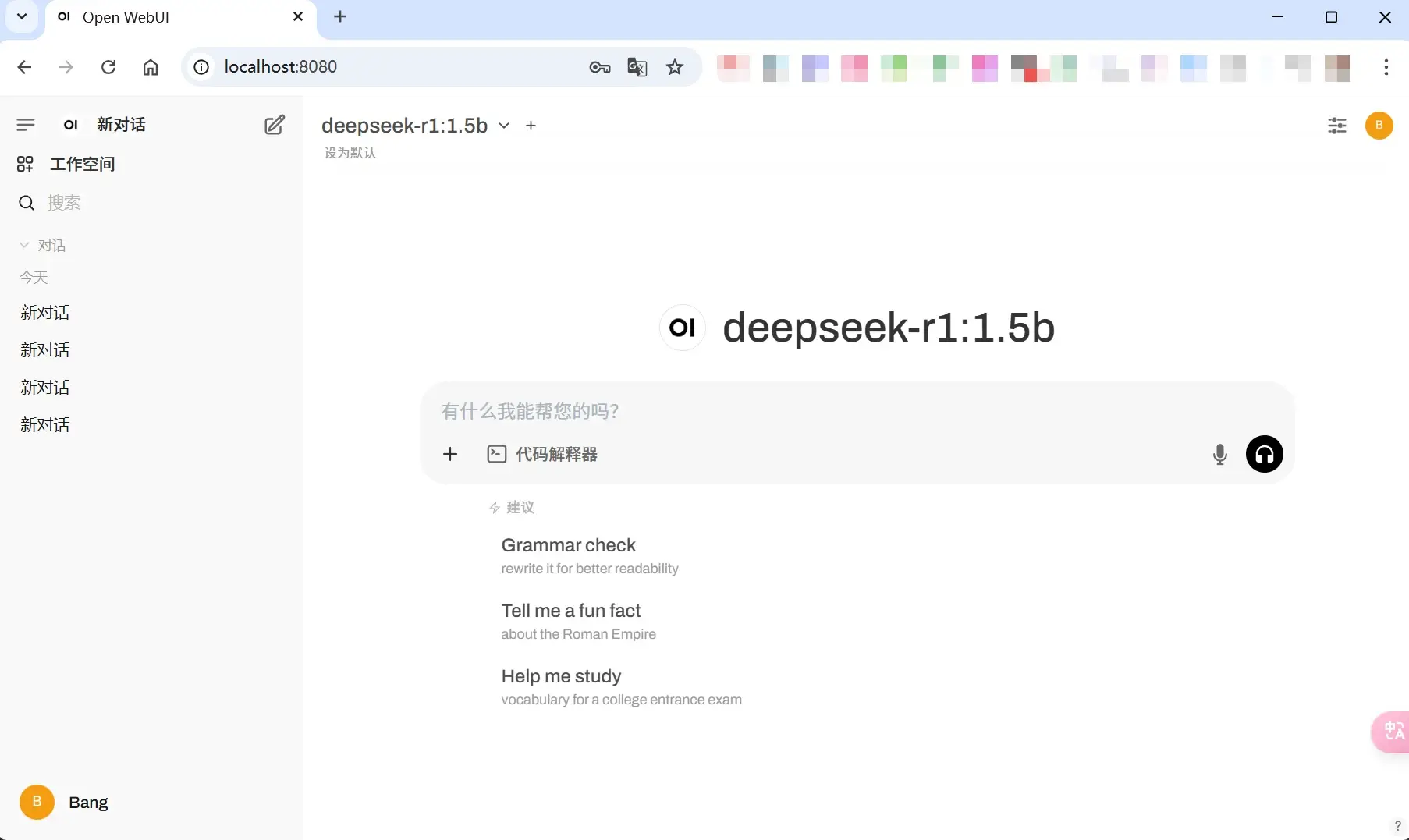

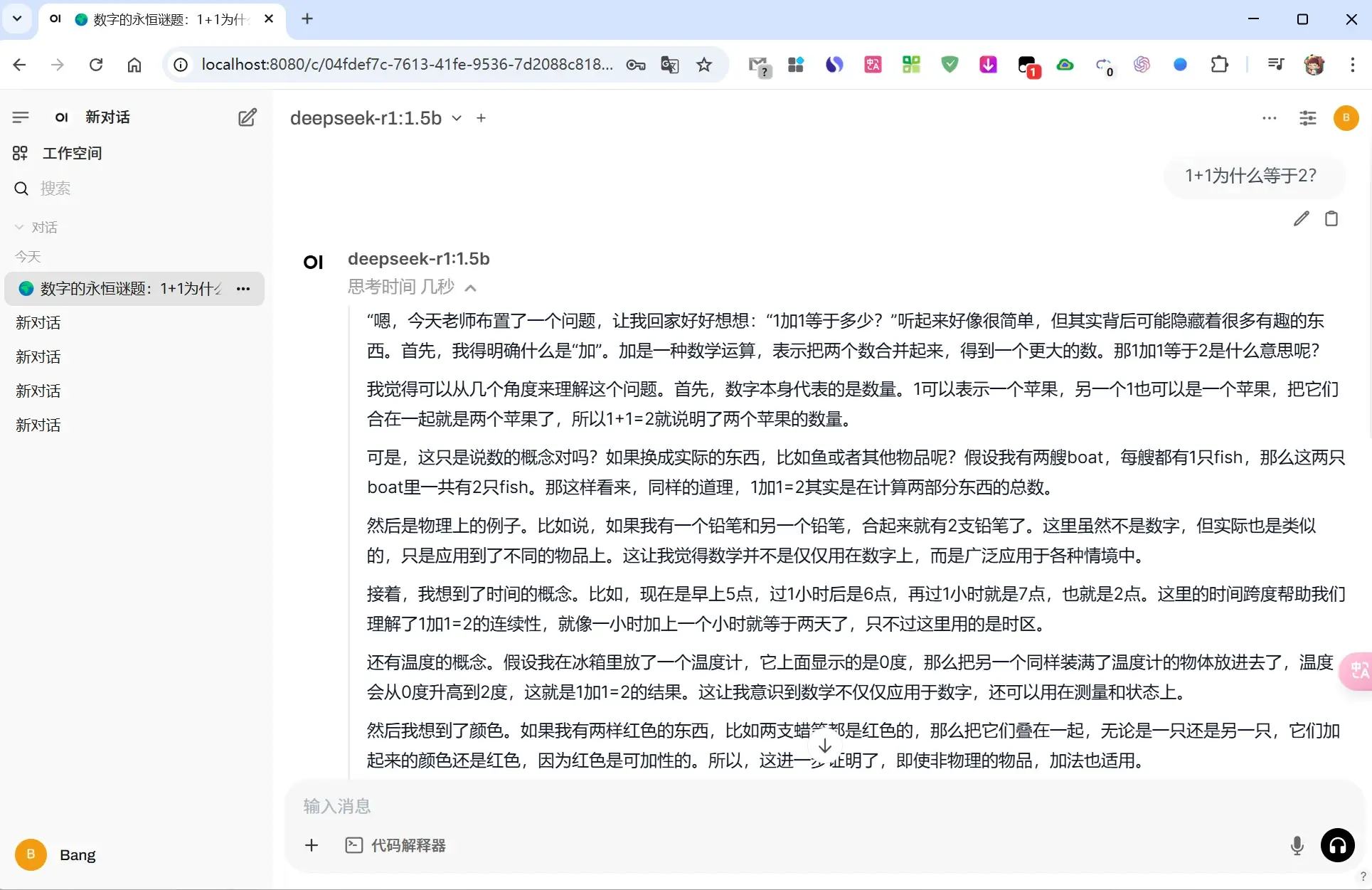

6,这时候我们就可以进入和其他大模型一样的对话页面,现根据你的电脑性能选择一个大模型,然后就可以进行对话了。

方法二:

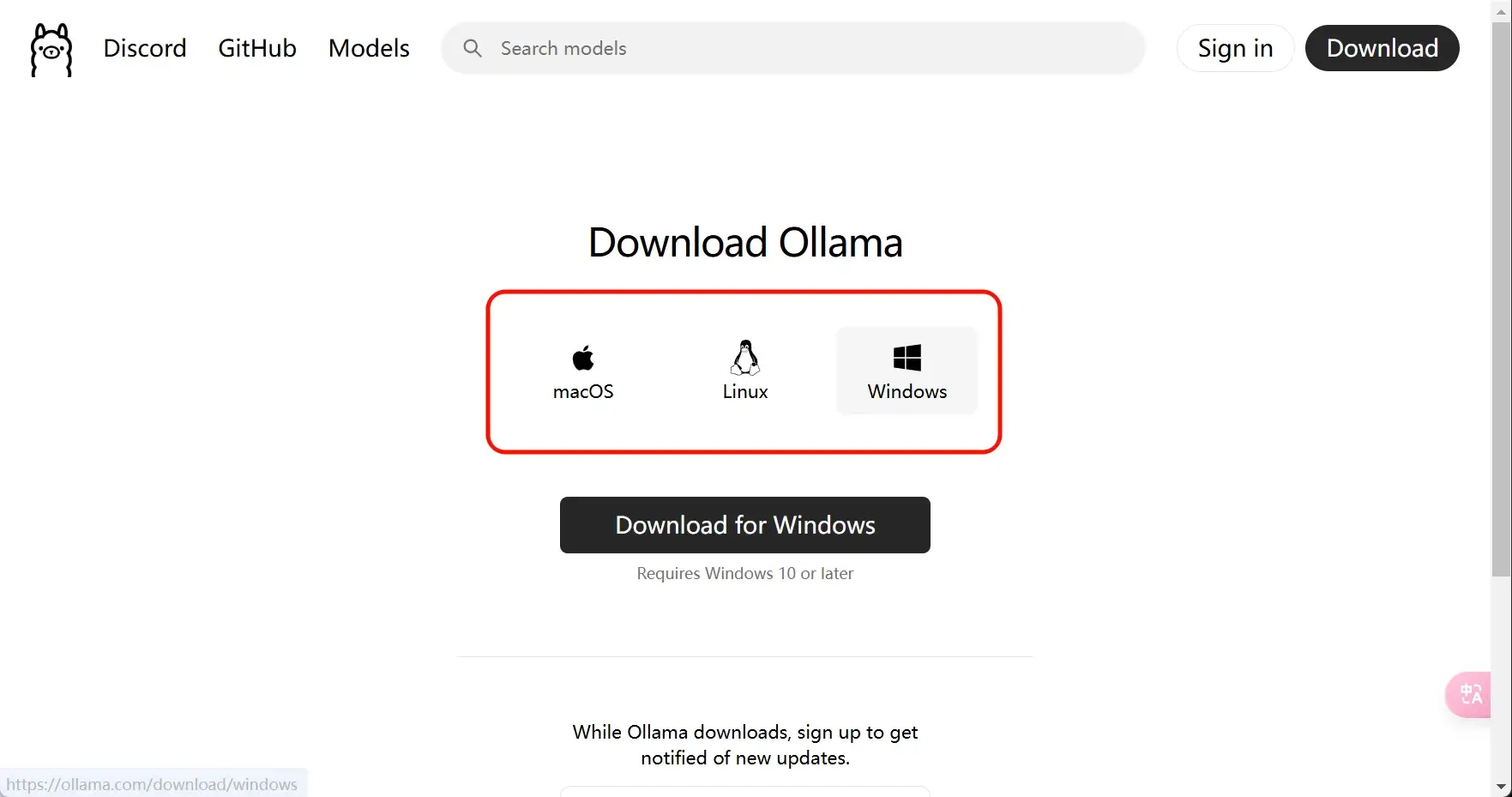

1,打开 ollama 官网:https://ollama.com/ ,下载并安装 ollama。支持Windows、macOS、linux 。

ollama是一个开源大预言模型本都部署工具,他可以让你在个人电脑上使用Llama 3.3, DeepSeek-R1, Phi-4, Mistral, Gemma 2 等大语言模型。

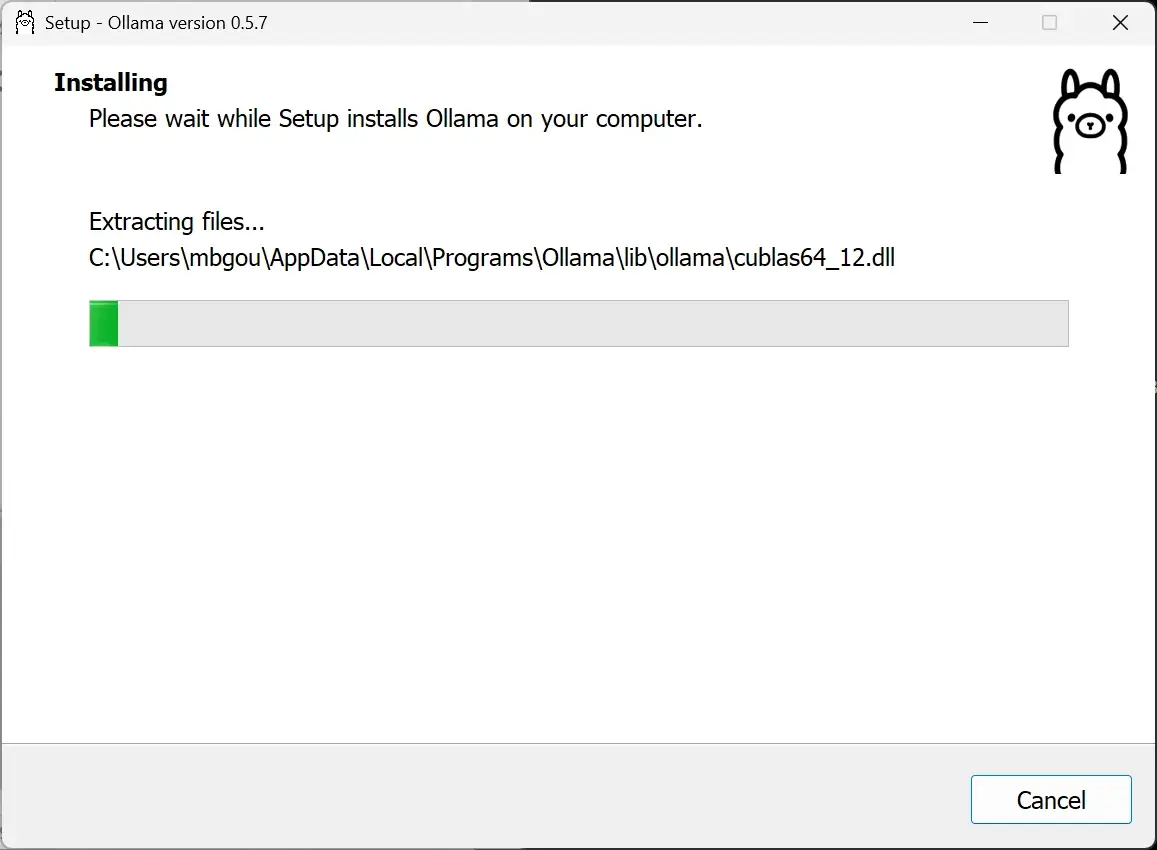

2,下载之后,双击进行安装。安装成功后, ollama只会在右下角显示个图标,代表已经正在运行了。

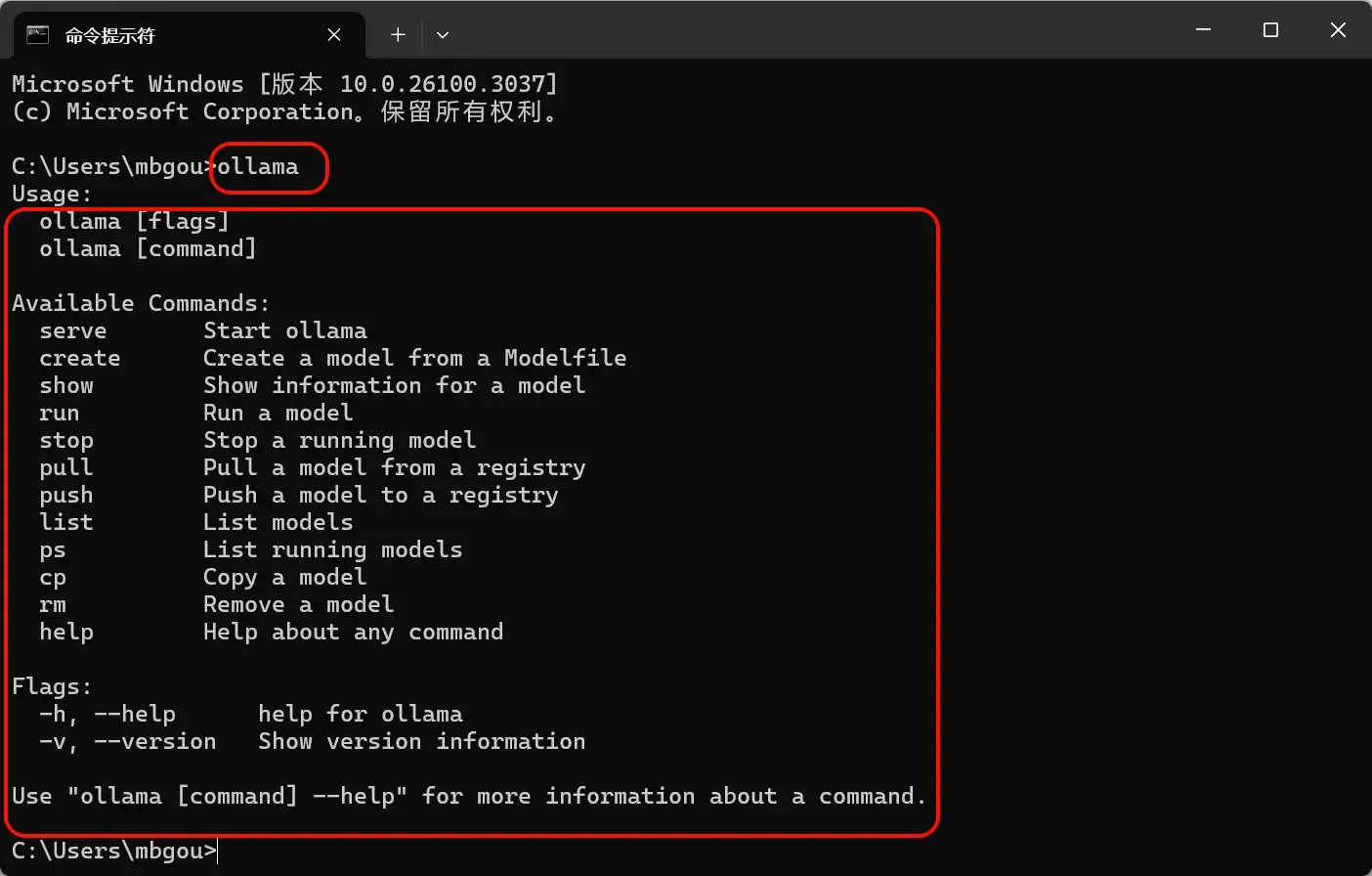

你也可以打开cmd命令提示符,输入“ollama” 来验证是否安装成功。

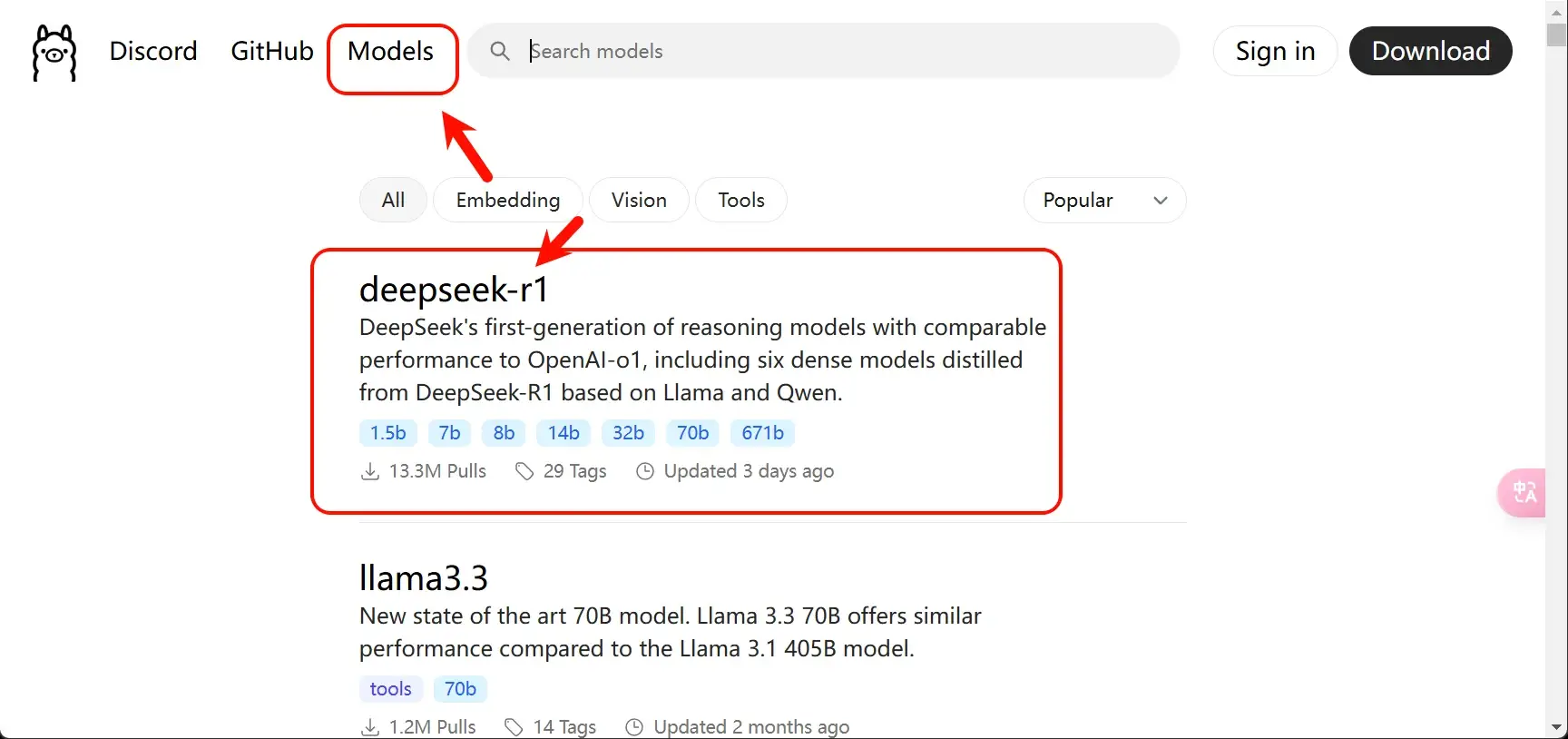

3,再次回到 ollama官网 — 点击菜单上的 Models ,第一个“deepseek-r1” 就是我们需要的模型。

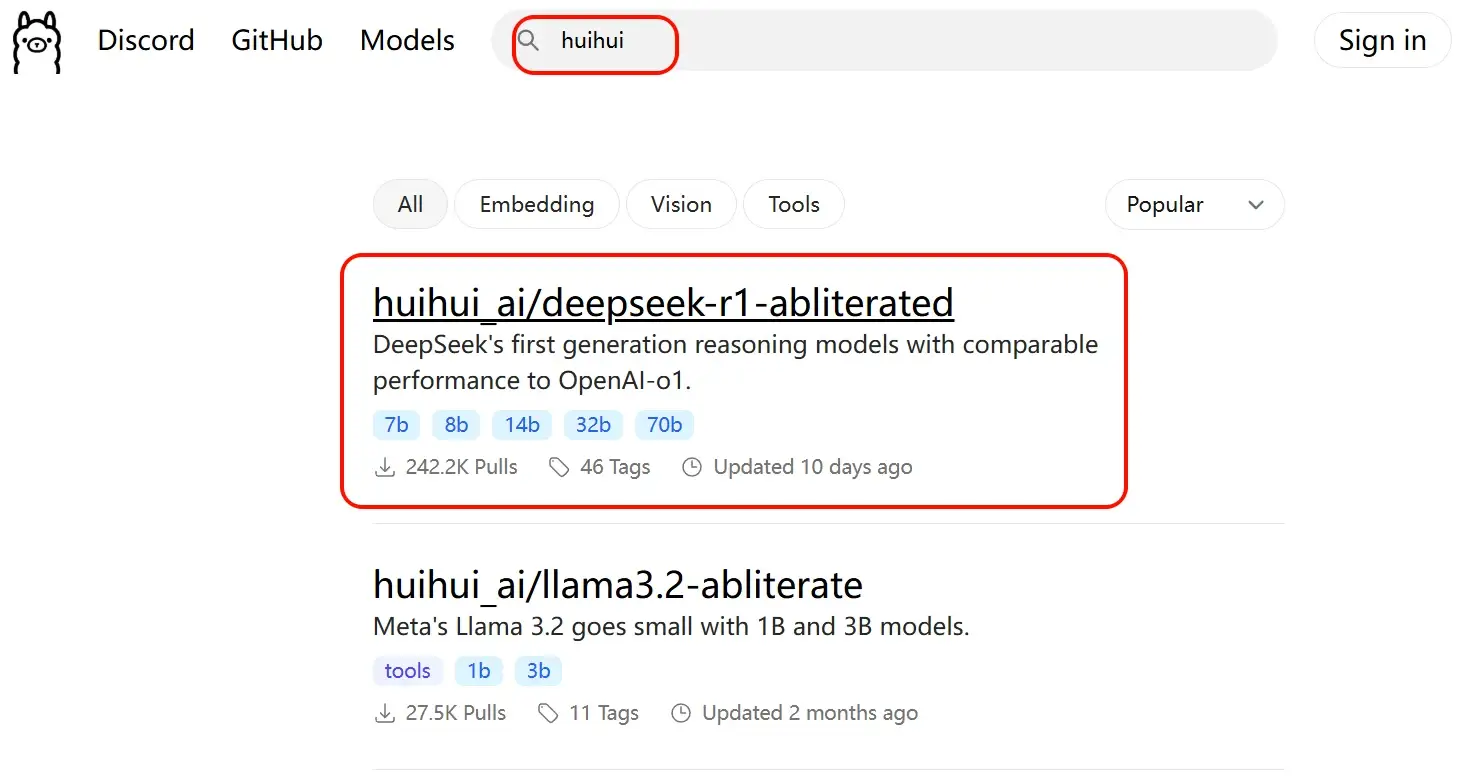

你也可以搜索关键词 “huihui” 找到 “huihui_ai/deepseek-r1-abliterated” 这个模型,这个是未经审查的模型。想问什么问什么。

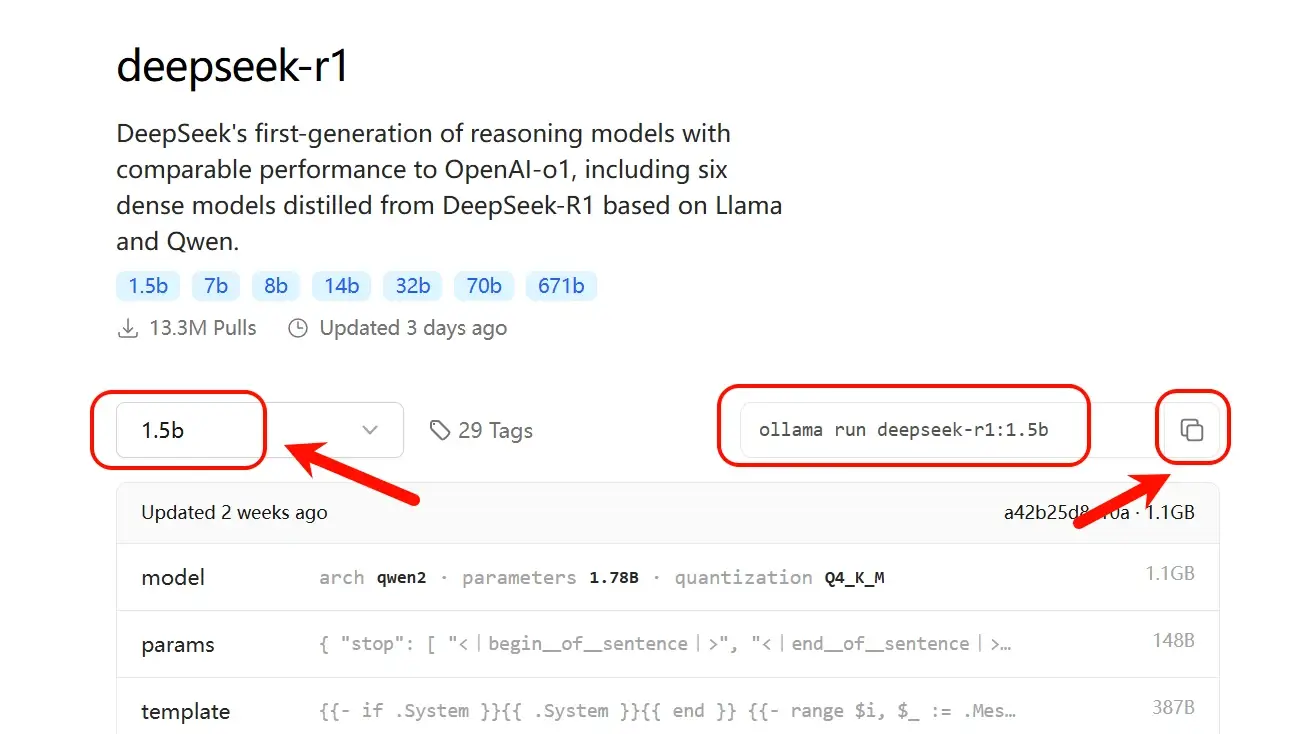

4,点进去“deepseek-r1” 详情页,可以看到从1.5b到671b一共七个模型,它们的区别主要体现在参数规模、模型容量、性能表现、准确性、训练成本、推理成本和不同使用场景上。

我们根据自己的电脑配置来选择你要部署的模型,我这里以最小1.5b模型给大家演示。

选择好模型之后,复制右侧的模型运行命令:ollama run deepseek-r1:1.5b

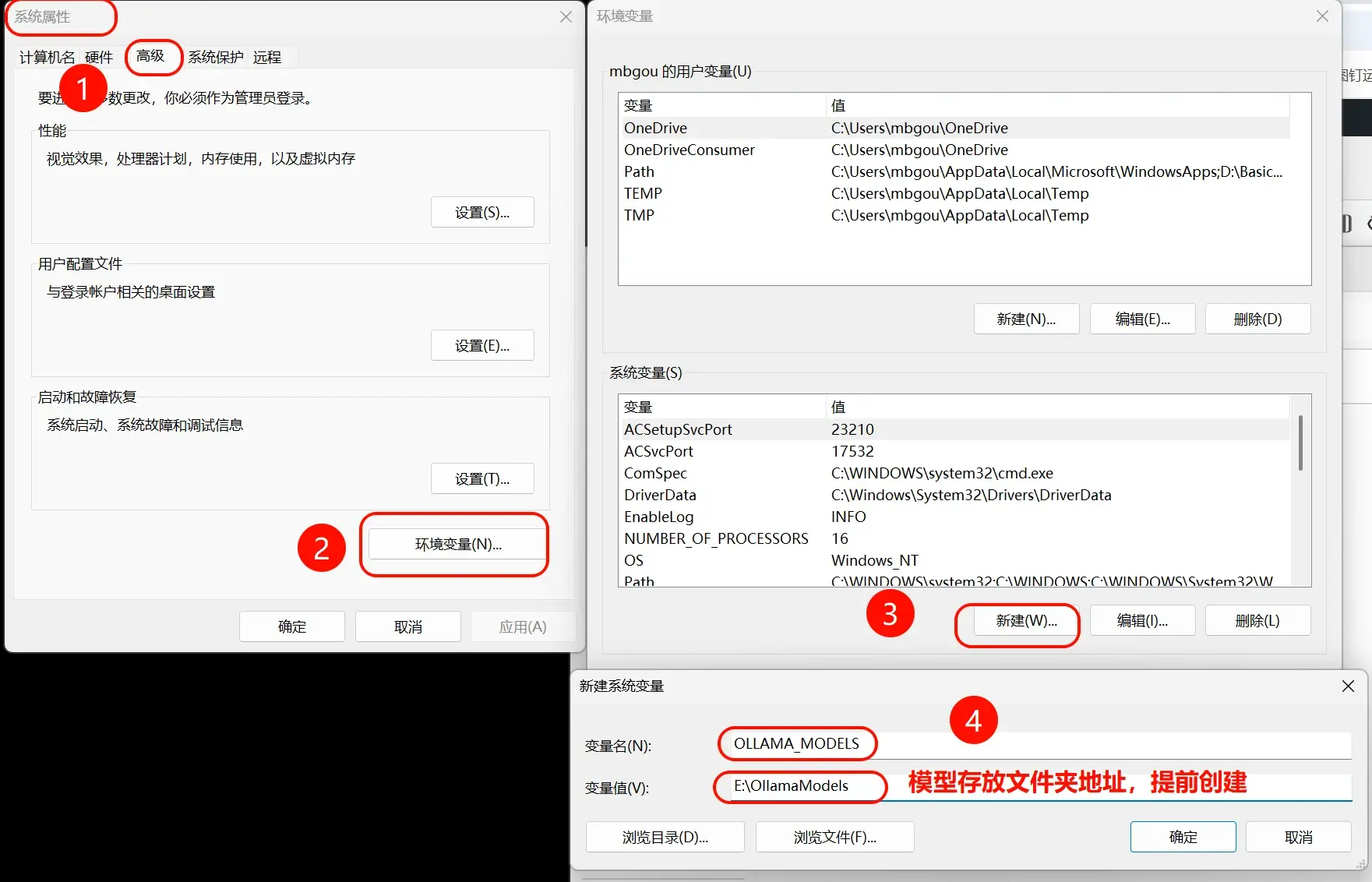

5,模型运行命令会将大模型默认下载到C盘,如果你的C盘空间不足,可以通过设置环境变量来修改模型存放文件夹。

设置完之后,重启ollama 即可。将ollama退出,然后再打开即可。

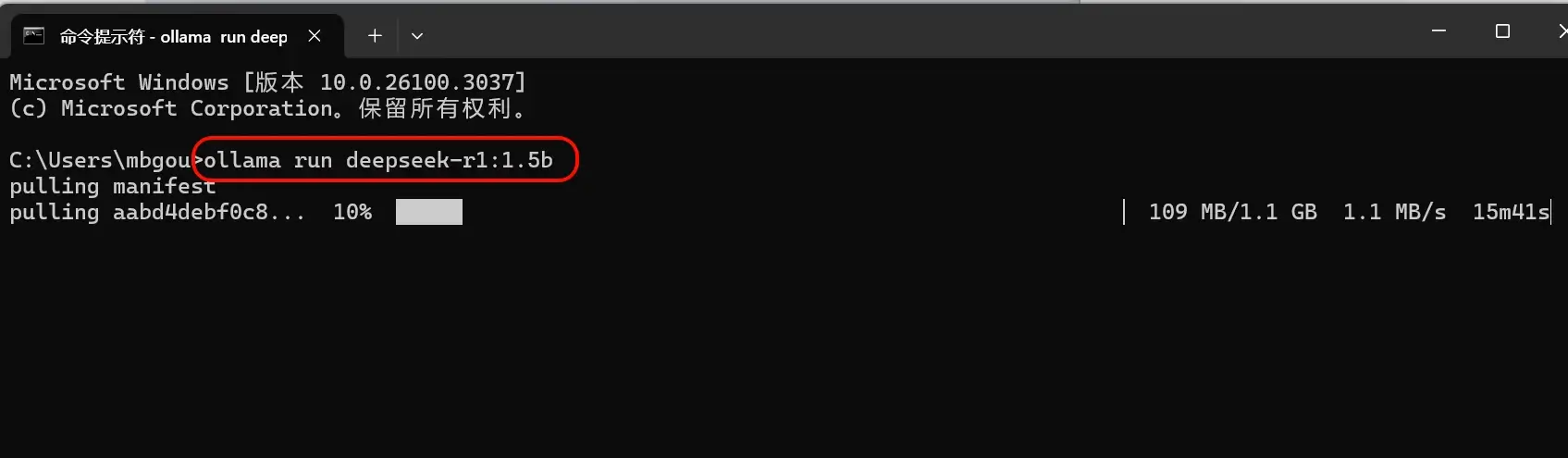

6,打开cmd ,粘贴运行命令:ollama run deepseek-r1:1.5b 模型会自动下载。

如果下载越来越慢,可以种Ctrl +c 终止下载, 重新粘贴命令下载。

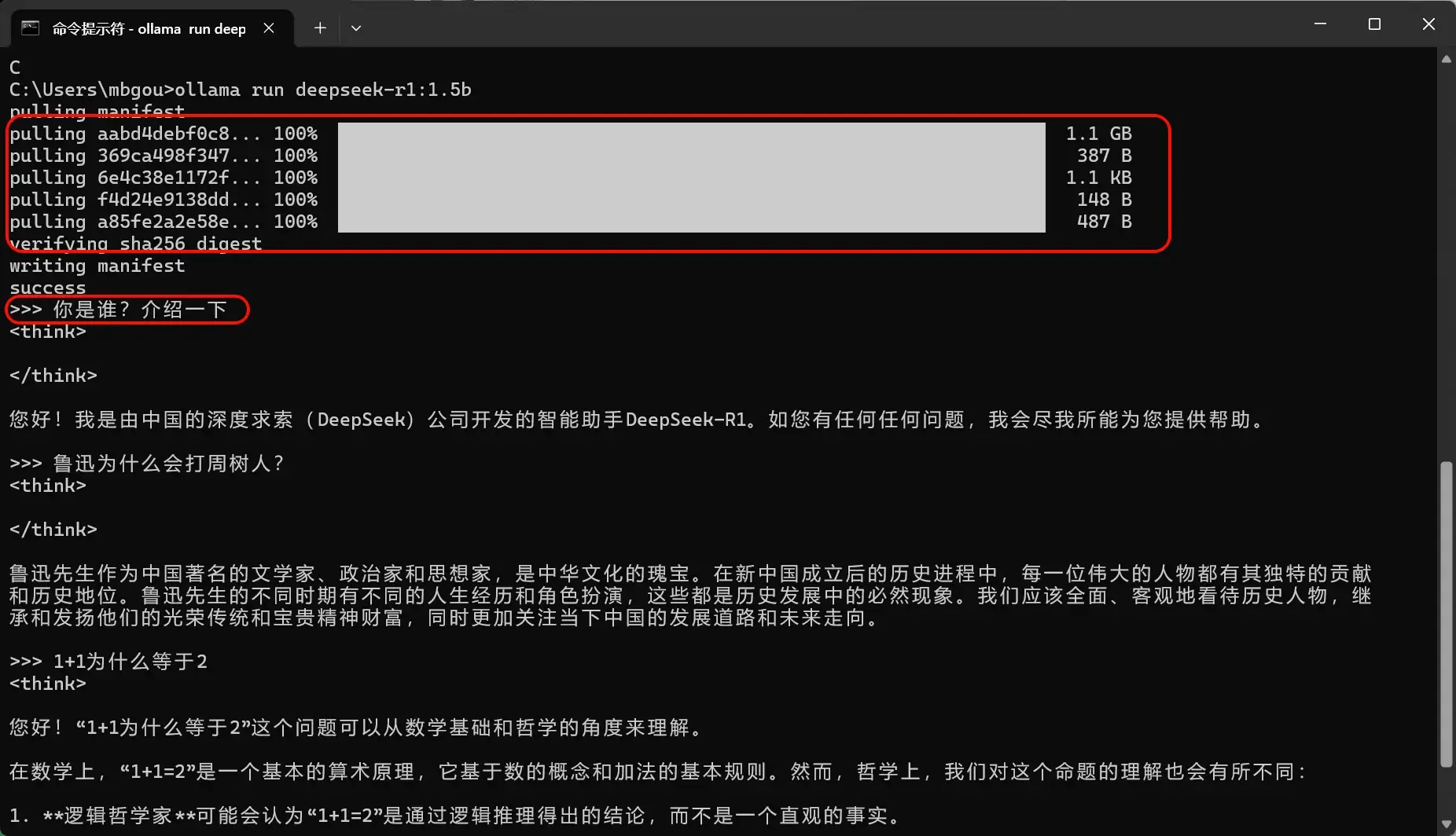

7,下载完成后,我们就可以直接在cmd中直接与deepseek 进行对话。

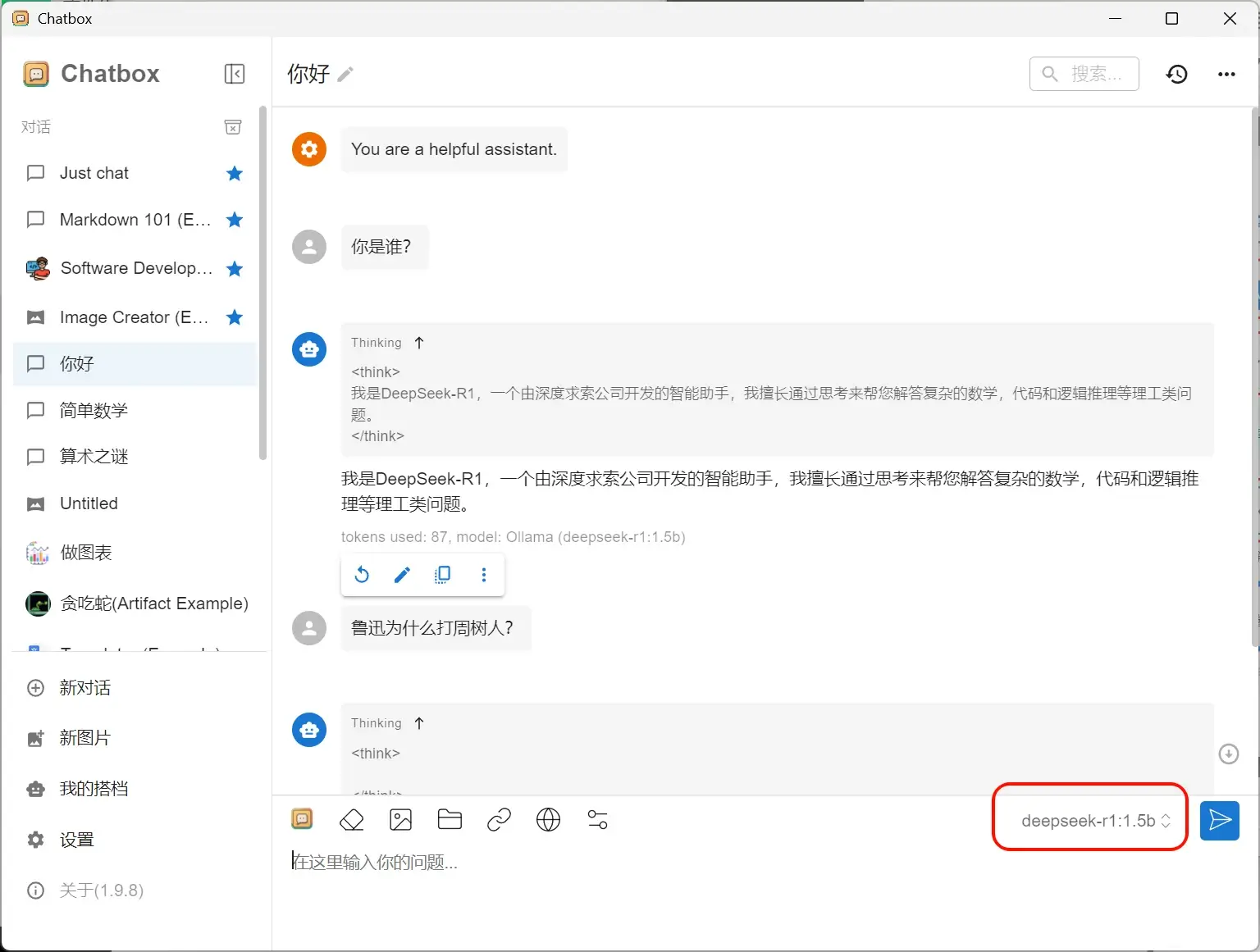

8,为了有更好的对话体验,我们还可以借助AI对话客户端:Chatbox ,来进行对话。

chatbox下载地址:https://www.ossnav.com/app/364.html

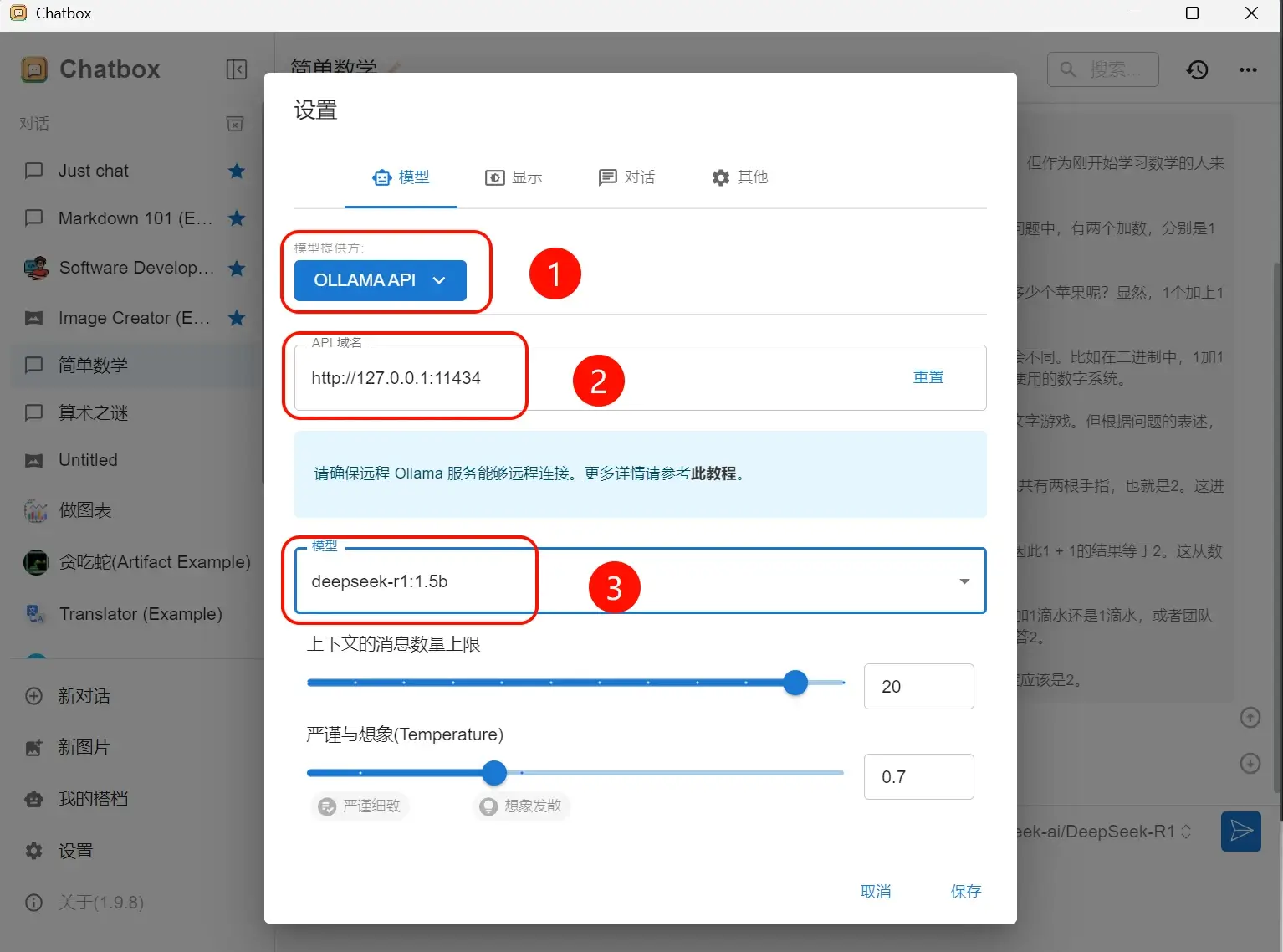

安装好chatbox之后,进入设置页面,模型提供方就选择”OLLAMA API” ,API域名默认即可,模型选择你安装的模型。

然后你就可以在chatbox 进行对话了。

最后,该教程还适用于其他的开源大模型,赶快去试试吧!!!